고정 헤더 영역

상세 컨텐츠

본문

https://byeolcardi.tistory.com/4

딥러닝으로 삼성전자 주가 예측하기 - (lstm)

딥러닝이라는 것 자체가 과거를 토대로 미래를 예측하는 것이기 때문에 과거의 주가 데이터를 이용하여 미래의 주가를 예측하려는 연구들은 상당히 많이 이루어지고 있습니다. 그것이 쉽게 이

byeolcardi.tistory.com

이전 포스트에서는 LSTM을 이용하여 삼성전자 주가를 예측했습니다. 이번 포스트에서는 bidirectional RNN (양방향 RNN)을 이용하여 삼성전자 주가를 예측해보려고 합니다. 해당 링크를 통하여 논문을 확인하실 수 있습니다.

bidirectional RNN의 정의

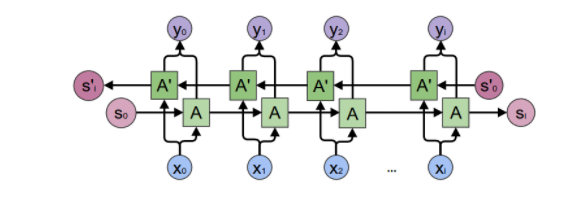

bidirectional RNN 이란 말 그대로 양방향 RNN을 말합니다. 일반적으로 RNN은 다음과 같은 구조를 가지고 있습니다.

방향이 단방향이기 때문에 정보의 불균형이 존재합니다. 이러한 단점을 극복하기 위하여 만들어진 것이 bidirectional RNN입니다.

LSTM와의 코드 비교

코드를 LSTM과 비교하면서 보면서 어떠한 차이점이 있는지 살펴보겠습니다. 전체 코드는 맨 뒤쪽에 작성하도록 하겠습니다.

#bidirectional-LSTM

backward_rnn_cells = tf.nn.rnn_cell.MultiRNNCell(

[lstm_cell(size_layer) for _ in range(num_layers)],

state_is_tuple = False,

)

forward_rnn_cells = tf.nn.rnn_cell.MultiRNNCell(

[lstm_cell(size_layer) for _ in range(num_layers)],

state_is_tuple = False,

)

#LSTM

rnn_cells = tf.nn.rnn_cell.MultiRNNCell(

[lstm_cell(size_layer) for _ in range(num_layers)],

state_is_tuple = False,

)코드를 보시면 lstm_cell함수에서 LSTM의 경우 rnn_cells이 단방향인 것에 비하여 bidirectional-LSTM은 backward, forward 양방향으로 진행되는 것을 확인하실 수 있습니다. 여기서 cell은 한 덩어리의 신경망으로 생각하시면 됩니다.

#bidirectional-LSTM

drop_backward = tf.contrib.rnn.DropoutWrapper(

backward_rnn_cells, output_keep_prob = forget_bias

)

forward_backward = tf.contrib.rnn.DropoutWrapper(

forward_rnn_cells, output_keep_prob = forget_bias

)

#LSTM

drop = tf.contrib.rnn.DropoutWrapper(

rnn_cells, output_keep_prob = forget_bias

)RNN cell을 쌓게 되면 overfitting의 위험성이 증가합니다. 그렇기 때문에 Dropout layer를 추가하는 것이 좋습니다. 해당 코드는 Dropout을 적용하는 코드입니다. 방향성이 있는 bidirectional-LSTM은 2개의 Dropout layer를 추가합니다. 해당 코드에서 forget_bias는 0.1로 선언했습니다.

#bidirectional-LSTM

self.backward_hidden_layer = tf.placeholder(

tf.float32, shape = (None, num_layers * 2 * size_layer)

)

self.forward_hidden_layer = tf.placeholder(

tf.float32, shape = (None, num_layers * 2 * size_layer)

)

#LSTM

self.hidden_layer = tf.placeholder(

tf.float32, (None, num_layers * 2 * size_layer구조적 특성상 hidden_layer도 bidirectional-LSTM은 양방향, LSTM은 단방향이라는 차이를 가지고 있습니다.

#bidirectional-LSTM

self.outputs, self.last_state = tf.nn.bidirectional_dynamic_rnn(

forward_backward,

drop_backward,

self.X,

initial_state_fw = self.forward_hidden_layer,

initial_state_bw = self.backward_hidden_layer,

dtype = tf.float32,

)

#LSTM

self.outputs, self.last_state = tf.nn.dynamic_rnn(

drop, self.X, initial_state = self.hidden_layer, dtype = tf.float32

)

그리고 동적으로 graph를 만들기 위하여 bidirectional-LSTM은 tf.nn.dynamic_rnn, LSTM은 tf.nn.bidirectional_dynamic_rnn를 사용합니다. tf.nn.bidirectional_dynamic_rnn는 tf.nn.dynamic_rnn와 같은 방식이지만 양방향이라는 차이점만 있습니다.

self.logits = tf.layers.dense(self.outputs[-1], output_size)

self.cost = tf.reduce_mean(tf.square(self.Y - self.logits))

self.optimizer = tf.train.AdamOptimizer(learning_rate).minimize(self.cost)그 이후에 layer를 쌓는 거나 optimizer에 있어서는 이전 포스트와 동일한 코드로 진행됩니다.

해당 부분을 제외하면 크게 차이점이 없습니다. bidirectional RNN을 이용한 삼성전자 주가 예측 코드 전문을 보여드리며 포스트를 마무리하겠습니다. 감사합니다.

bidrectional-lstm 코드

!pip install yfinance

%tensorflow_version 1.x

import sys

import warnings

if not sys.warnoptions:

warnings.simplefilter('ignore')

import tensorflow as tf

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

import pandas as pd

from sklearn.preprocessing import MinMaxScaler

from datetime import datetime

from datetime import timedelta

from tqdm import tqdm

sns.set()

tf.compat.v1.random.set_random_seed(1234)

%matplotlib inline

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import yfinance as yf

samsung_df = yf.download('005930.KS',

start='2020-01-01',

end='2022-03-03',

progress=False)

df = samsung_dfminmax = MinMaxScaler().fit(df.iloc[:, 4:5].astype('float32')) # Close index

df_log = minmax.transform(df.iloc[:, 4:5].astype('float32')) # Close index

df_log = pd.DataFrame(df_log)

test_size = 30

simulation_size = 5

df_train = df_log.iloc[:-test_size]

df_test = df_log.iloc[-test_size:]

df.shape, df_train.shape, df_test.shapeclass Model:

def __init__(

self,

learning_rate,

num_layers,

size,

size_layer,

output_size,

forget_bias = 0.1,

):

def lstm_cell(size_layer):

return tf.nn.rnn_cell.LSTMCell(size_layer, state_is_tuple = False)

backward_rnn_cells = tf.nn.rnn_cell.MultiRNNCell(

[lstm_cell(size_layer) for _ in range(num_layers)],

state_is_tuple = False,

)

forward_rnn_cells = tf.nn.rnn_cell.MultiRNNCell(

[lstm_cell(size_layer) for _ in range(num_layers)],

state_is_tuple = False,

)

self.X = tf.placeholder(tf.float32, (None, None, size))

self.Y = tf.placeholder(tf.float32, (None, output_size))

drop_backward = tf.contrib.rnn.DropoutWrapper(

backward_rnn_cells, output_keep_prob = forget_bias

)

forward_backward = tf.contrib.rnn.DropoutWrapper(

forward_rnn_cells, output_keep_prob = forget_bias

)

self.backward_hidden_layer = tf.placeholder(

tf.float32, shape = (None, num_layers * 2 * size_layer)

)

self.forward_hidden_layer = tf.placeholder(

tf.float32, shape = (None, num_layers * 2 * size_layer)

)

self.outputs, self.last_state = tf.nn.bidirectional_dynamic_rnn(

forward_backward,

drop_backward,

self.X,

initial_state_fw = self.forward_hidden_layer,

initial_state_bw = self.backward_hidden_layer,

dtype = tf.float32,

)

self.outputs = tf.concat(self.outputs, 2)

self.logits = tf.layers.dense(self.outputs[-1], output_size)

self.cost = tf.reduce_mean(tf.square(self.Y - self.logits))

self.optimizer = tf.train.AdamOptimizer(learning_rate).minimize(

self.cost

)

def calculate_accuracy(real, predict):

real = np.array(real) + 1

predict = np.array(predict) + 1

percentage = 1 - np.sqrt(np.mean(np.square((real - predict) / real)))

return percentage * 100

def anchor(signal, weight):

buffer = []

last = signal[0]

for i in signal:

smoothed_val = last * weight + (1 - weight) * i

buffer.append(smoothed_val)

last = smoothed_val

return buffernum_layers = 1

size_layer = 128

timestamp = 5

epoch = 300

dropout_rate = 0.8

future_day = test_size

learning_rate = 0.01def forecast():

tf.reset_default_graph()

modelnn = Model(

learning_rate, num_layers, df_log.shape[1], size_layer, df_log.shape[1], dropout_rate

)

sess = tf.InteractiveSession()

sess.run(tf.global_variables_initializer())

date_ori = pd.to_datetime(df.iloc[:, 0]).tolist()

pbar = tqdm(range(epoch), desc = 'train loop')

for i in pbar:

init_value_forward = np.zeros((1, num_layers * 2 * size_layer))

init_value_backward = np.zeros((1, num_layers * 2 * size_layer))

total_loss, total_acc = [], []

for k in range(0, df_train.shape[0] - 1, timestamp):

index = min(k + timestamp, df_train.shape[0] - 1)

batch_x = np.expand_dims(

df_train.iloc[k : index, :].values, axis = 0

)

batch_y = df_train.iloc[k + 1 : index + 1, :].values

logits, last_state, _, loss = sess.run(

[modelnn.logits, modelnn.last_state, modelnn.optimizer, modelnn.cost],

feed_dict = {

modelnn.X: batch_x,

modelnn.Y: batch_y,

modelnn.backward_hidden_layer: init_value_backward,

modelnn.forward_hidden_layer: init_value_forward,

},

)

init_value_forward = last_state[0]

init_value_backward = last_state[1]

total_loss.append(loss)

total_acc.append(calculate_accuracy(batch_y[:, 0], logits[:, 0]))

pbar.set_postfix(cost = np.mean(total_loss), acc = np.mean(total_acc))

future_day = test_size

output_predict = np.zeros((df_train.shape[0] + future_day, df_train.shape[1]))

output_predict[0] = df_train.iloc[0]

upper_b = (df_train.shape[0] // timestamp) * timestamp

init_value_forward = np.zeros((1, num_layers * 2 * size_layer))

init_value_backward = np.zeros((1, num_layers * 2 * size_layer))

for k in range(0, (df_train.shape[0] // timestamp) * timestamp, timestamp):

out_logits, last_state = sess.run(

[modelnn.logits, modelnn.last_state],

feed_dict = {

modelnn.X: np.expand_dims(

df_train.iloc[k : k + timestamp], axis = 0

),

modelnn.backward_hidden_layer: init_value_backward,

modelnn.forward_hidden_layer: init_value_forward,

},

)

init_value_forward = last_state[0]

init_value_backward = last_state[1]

output_predict[k + 1 : k + timestamp + 1] = out_logits

if upper_b != df_train.shape[0]:

out_logits, last_state = sess.run(

[modelnn.logits, modelnn.last_state],

feed_dict = {

modelnn.X: np.expand_dims(df_train.iloc[upper_b:], axis = 0),

modelnn.backward_hidden_layer: init_value_backward,

modelnn.forward_hidden_layer: init_value_forward,

},

)

output_predict[upper_b + 1 : df_train.shape[0] + 1] = out_logits

future_day -= 1

date_ori.append(date_ori[-1] + timedelta(days = 1))

init_value_forward = last_state[0]

init_value_backward = last_state[1]

for i in range(future_day):

o = output_predict[-future_day - timestamp + i:-future_day + i]

out_logits, last_state = sess.run(

[modelnn.logits, modelnn.last_state],

feed_dict = {

modelnn.X: np.expand_dims(o, axis = 0),

modelnn.backward_hidden_layer: init_value_backward,

modelnn.forward_hidden_layer: init_value_forward,

},

)

init_value_forward = last_state[0]

init_value_backward = last_state[1]

output_predict[-future_day + i] = out_logits[-1]

date_ori.append(date_ori[-1] + timedelta(days = 1))

output_predict = minmax.inverse_transform(output_predict)

deep_future = anchor(output_predict[:, 0], 0.3)

return deep_future[-test_size:]results = []

for i in range(simulation_size):

print('simulation %d'%(i + 1))

results.append(forecast())accuracies = [calculate_accuracy(df['Close'].iloc[-test_size:].values, r) for r in results]

plt.figure(figsize = (15, 5))

for no, r in enumerate(results):

plt.plot(r, label = 'forecast %d'%(no + 1))

plt.plot(df['Close'].iloc[-test_size:].values, label = 'true trend', c = 'black')

plt.legend()

plt.title('average accuracy: %.4f'%(np.mean(accuracies)))

plt.show()'머신러닝 > 주가 예측' 카테고리의 다른 글

| Gemma3 기반 LoRA 튜닝으로 주식 예측 모델 만들기 (0) | 2025.04.17 |

|---|---|

| keras를 통한 머신러닝 간단한 애플 주가 예측 (0) | 2023.07.27 |

| 딥러닝으로 삼성전자 주가 예측하기 - (seq2seq) (0) | 2022.06.02 |

| 딥러닝으로 삼성전자 주가 예측하기 - (GRU) (0) | 2022.05.13 |

| 딥러닝으로 삼성전자 주가 예측하기 - (lstm) (0) | 2022.03.25 |